针对当前人工智能视觉模型普遍存在的偏见问题,索尼AI团队近日发布了名为“Fair Human-Centric Image Benchmark(FHIBE)”的全新数据集,旨在推动公平性测试和伦理数据收集的标准化。

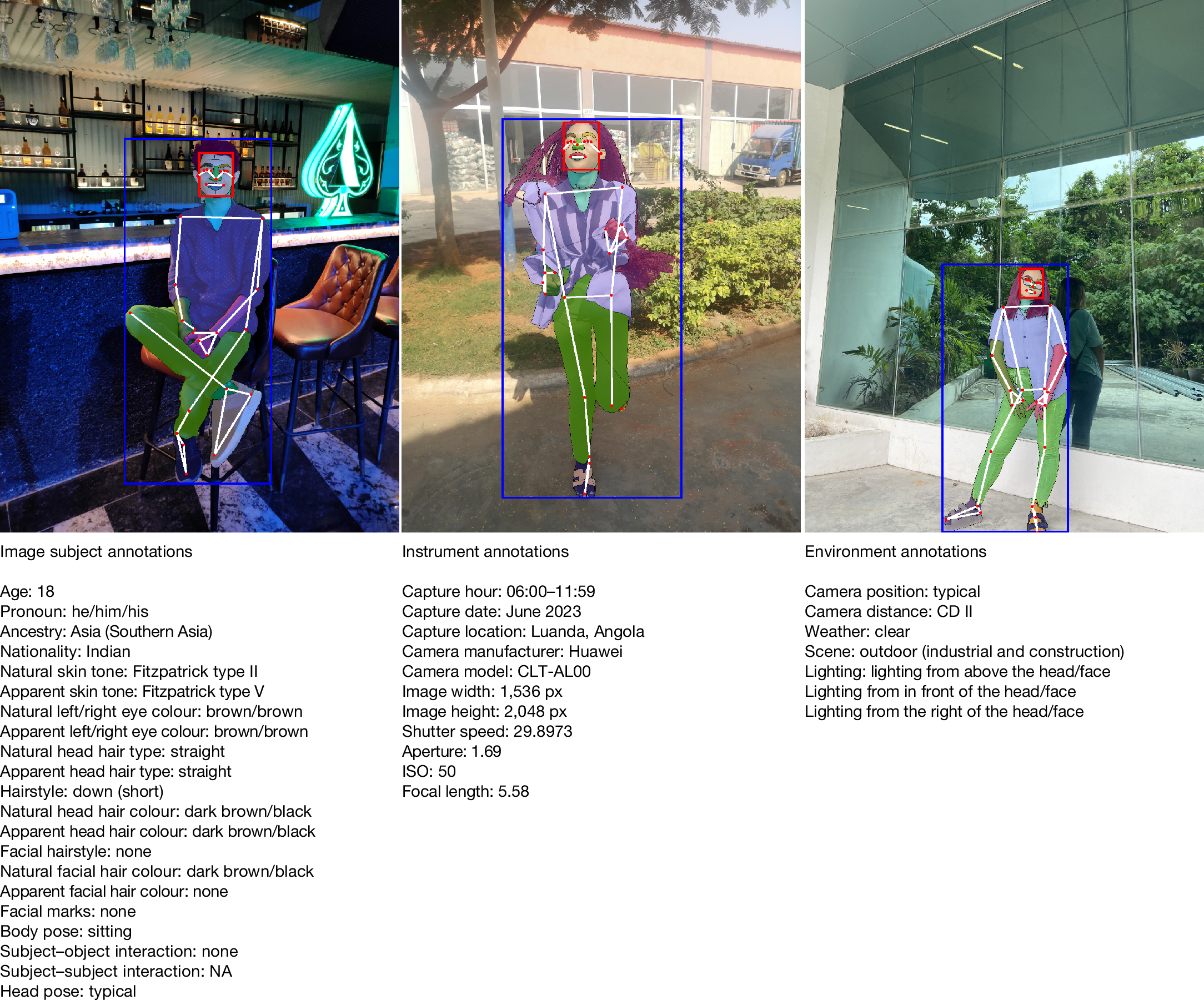

该数据集的所有图像均经过本人同意收集,覆盖全球81个国家和地区,共包含10318张图片和1981个独立受试者,每张图片都配有详细标注,包括边框框定、分割蒙版以及相机参数等专业信息,便于开发者对模型进行细致评估。

索尼AI全球AI治理负责人Alice Xiang表示,计算机视觉领域的一个误区是认为模型由于依赖数据和算法能够客观地反映现实,而事实上模型训练过程中的数据偏见会直接影响实际表现。例如,在中国,部分手机面部识别系统曾因训练数据中亚洲人脸占比不足,导致家庭成员意外解锁设备并完成支付,从而引发安全隐患。此外,现有视觉模型还曾出现将女性医生错误分类为护士,或无意中强化职业与种族、性别刻板印象等问题。

此前,多数用于评估公平性的计算机视觉数据集均未征得被拍摄者同意,甚至直接从互联网平台爬取图像,这引发了诸多版权及隐私争议。对比之下,FHIBE的所有数据采集均有充分的同意和补偿流程公开记录,被认为为行业树立了新的伦理标准。

索尼AI团队基于FHIBE测试发现,部分模型因发型多样性而在处理指定性别代词(如“She/Her/Hers”)时准确率下降,模型也可能在职业识别任务中对某些族群不合理地关联犯罪活动。团队强调,FHIBE能够帮助开发者及时发现和纠正这些偏差,推动行业在数据收集环节更加重视伦理和公平,激励研发人员投入更多资源完善数据层创新。

目前,虽然美国联邦层面尚未出台专门支持AI伦理和公平的政策,但包括欧盟AI法案以及美国部分州份相关法规,已开始要求在高风险领域对算法偏见进行审核。索尼集团已经在AI伦理评估流程中采用了FHIBE数据集,并遵循AI道德规范主动审查业务模型的公平性。

Alice Xiang认为,“数据虚无主义”在行业中日益盛行,而FHIBE的实践则表明,AI技术完全可以依靠获得同意及补偿的数据进行开发。尽管当前FHIBE规模尚小,不足以支撑大数据训练,但其意义在于为行业提供方法示范,并引发对数据层创新的更多关注,这仍是当前AI领域亟待解决的重要课题。