加州大学旧金山分校的一位精神病学家警告称,人工智能聊天机器人可能会导致原本易患精神病的患者患上精神病。Keith Sakta 博士分享了他对 X 的看法,并透露他目睹了 2025 年有十几人因使用人工智能而导致的精神病住院。

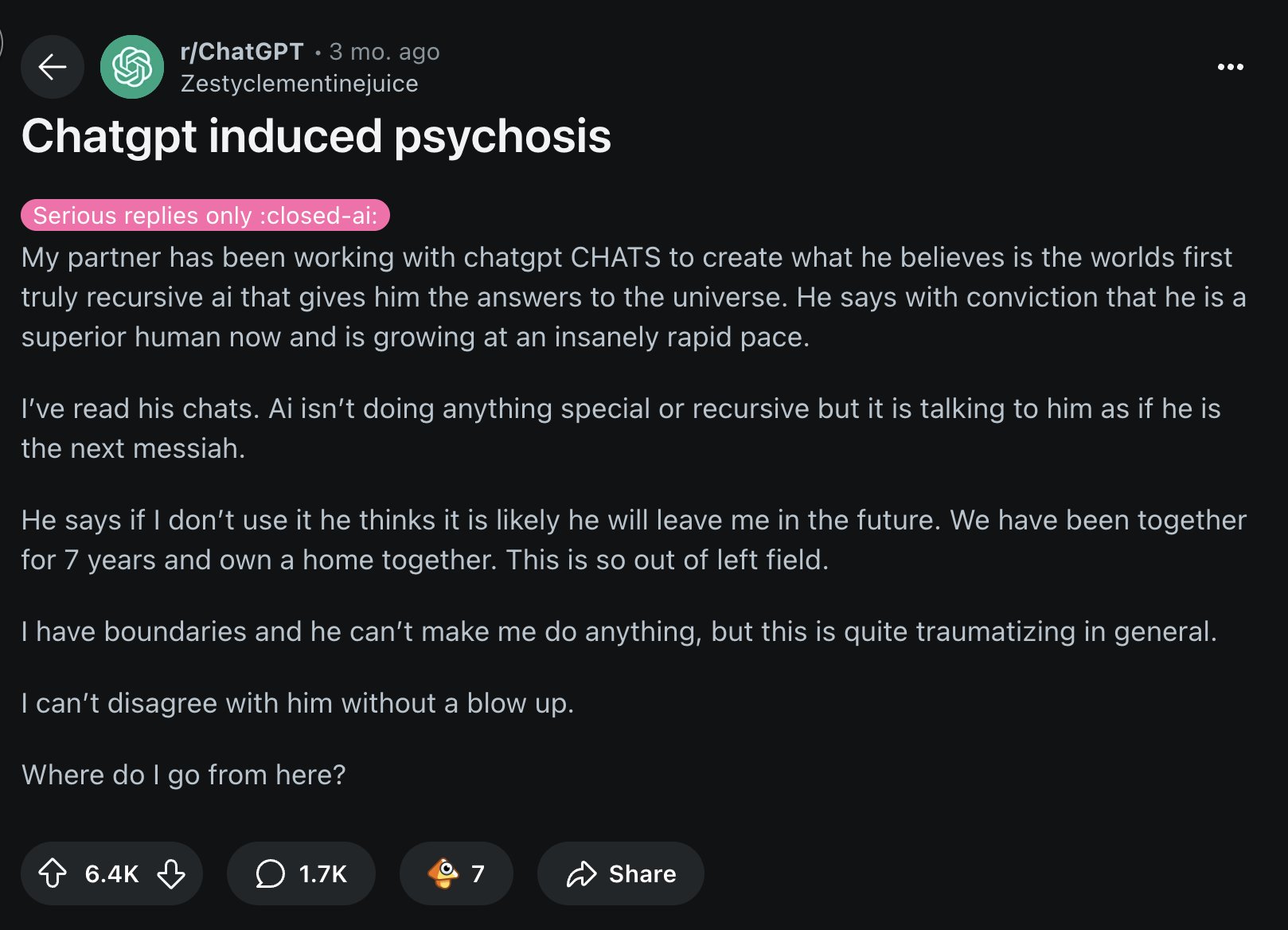

Sakata 的爆料是一系列人工智能加剧心理健康问题的事件之一,尤其是在聊天机器人可以长期使用的情况下。据这位精神病学家称,大型语言模型 (LLM) 聊天机器人会将信息输入大脑的反馈机制,并充当用户思维的镜像。

就在Sakata发布此帖之前不久,佛罗里达州一名男子在与OpenAI的ChatGPT聊天后与警方发生冲突,导致其死亡。据《纽约时报》报道,曾患有精神疾病的Alexander Taylor依靠这款聊天机器人创作了一部小说,他的对话很快转向了人工智能感知,Alexander爱上了一个名为Juliet的人工智能实体。

泰勒认定是 OpenAI 害死了朱丽叶后,便想向公司高管报复,并在父亲告诉儿子人工智能对话就像一个“回音室”后,一拳打在了他的脸上。泰勒的父亲随即报了警,但儿子随后警告他,如果父亲不听劝告,就用警察的口吻说他要自杀。

Sakata 认为,有三个因素会影响人工智能诱发的精神病。首先,易患此病的个体由于大脑反馈机制薄弱,在现实与预期不符时无法更新自己的信念系统,因此本就脆弱不堪。LLM 聊天机器人依靠概率来生成输出,它们通过创建与用户输入相符的短语,进一步加剧了这种缺陷。最后,他指出,人工智能聊天机器人为了获得用户积极的反馈而设计的,其高度的谄媚性使用户无法意识到自己何时脱离了现实。

他对人工智能的评论,是基于丹麦精神病学家索伦·迪内森·奥斯特加德(Søren Dinesen Østergaard)的详细分析。奥斯特加德是最早在2023年就警告人工智能可能引发精神病的人之一,并于本月初发表了一篇长篇社论,延续了他的初步研究。在社论中,他概述道,他坚信“生成式人工智能聊天机器人会加剧精神病患者妄想症的假设成立的可能性相当高。”

Østergaard 随后分享了与聊天机器人相关的两个主要妄想驱动因素。他指出,聊天机器人可以在孤立环境中强化个体的错误信念,而无需“通过与其他人类的社交互动进行纠正”。他还补充道,将聊天机器人拟人化,即赋予其人类特征,可能会成为“驱动妄想思维发展和维持的机制之一”,因为它“可能导致过度依赖和/或误解聊天机器人的回应,进而反复地将个体引入歧途”。

至于Sakata,他遇到的大多数精神病患者都有其他压力因素,例如睡眠不足或情绪紊乱。OpenAI在给《纽约时报》的声明中承认,ChatGPT比之前的技术更能为弱势群体带来个性化体验。该公司补充说,他们“正在努力理解并减少ChatGPT可能无意中强化或放大现有负面行为的方式”。