自动驾驶的商业化落地正在全球范围内加速推进。截至2025年5月,Waymo在美国旧金山、洛杉矶、凤凰城和奥斯汀运营的自动驾驶出租车达到1500辆,每周完成超过25万次付费出行服务;百度Apollo已在全球部署超1000辆无人驾驶汽车,累计提供超1100万次出行服务,安全行驶里程超过1.7亿公里。

大规模落地仿佛意味着技术已经成熟,其实不然,关于自动驾驶,还有很多尚未达成共识的流派分歧。

比如,传感器方案,纯视觉和多传感器融合方案该如何抉择?系统架构上,采用模块化设计,还是拥抱新兴的端到端架构?更进一步,关于如何理解世界,VLA和VLM孰优孰劣?

这些悬而未决的争议,正引领着自动驾驶驶向尚未完全确定的未来。而理解这些不尽相同的技术路线,就是理解自动驾驶从哪里来、到哪里去,如何实现技术的自我进化。

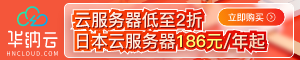

眼睛之争

纯视觉vs多传感器融合

一切始于“看见”。汽车如何感知世界,是自动驾驶的基石。在这个问题上存在着对峙已久的两大阵营,且双方至今未休。

故事最早可以追溯到2004年美国莫哈韦沙漠的一场挑战赛。

那时,美国国防高级研究计划局设立了200万美元的奖金,吸引数十支顶尖高校和科研机构参与,试图解答“如何让车辆感知周围环境?”的问题。

卡内基梅隆大学和斯坦福大学等团队选择的激光雷达胜出。这项能生成精确3D点云图的技术奠定了早期自动驾驶发展路线,被Google旗下的Waymo继承和发展。

然而,这一派有个致命软肋:成本。一套激光雷达系统造价高达7.5万美元,比车还贵,注定只能走小规模精英路线,难以大规模商业化。

十年后,特斯拉代表的视觉派走出了另一条路。

他们主张大道至简:“人类靠一双眼睛和一个大脑就能开车,机器为何不能?”

2014年,特斯拉推出Autopilot系统,采用Mobileye的视觉方案,选择了以摄像头为主的视觉方案。2016年,埃隆·马斯克公开表示“激光雷达是徒劳的”,正式确立了纯视觉技术路线。

团队通过8个环绕摄像头模拟人类视野,依靠深度学习算法从二维图像中重建三维环境。纯视觉方案成本极低,能够大规模商业化。而通过卖出更多车,收集更多海量真实世界数据,形成一个“数据飞轮”,反哺算法迭代,越用越强。

但摄像头是“被动”传感器,严重依赖环境光。在逆光、眩光、黑夜、大雨、大雾等情况下,性能会显著下降,远远比不上激光雷达。

以激光雷达为主的多传感器融合方案认为,机器的智能在可见的未来都无法完全媲美人类基于经验的常识和直觉,恶劣天气下必须通过激光雷达等硬件冗余来弥补软件的不足。

可以说,纯视觉将所有压力都集中在算法上,赌的是智能化的未来;多传感器融合更注重工程落地,选的是经过验证的现实方案。

目前,主流车企(Waymo、小鹏、蔚来等)都站在多传感器融合的阵营。他们认为安全是自动驾驶不可逾越的红线,而冗余是保障安全的唯一途径。

值得注意的是,两条路线并非完全泾渭分明,而是在相互学习和融合:纯视觉方案也在引入更多的传感器;多传感器融合方案中,视觉算法的地位也越来越高,成为理解场景语义的关键。

触觉之争

激光雷达vs 4D毫米波雷达

即使在多传感器融合派内部,也藏着一个选择题:

毫米波雷达成本仅数百元,激光雷达早期要数万美元,为什么还要花大价钱装激光雷达?

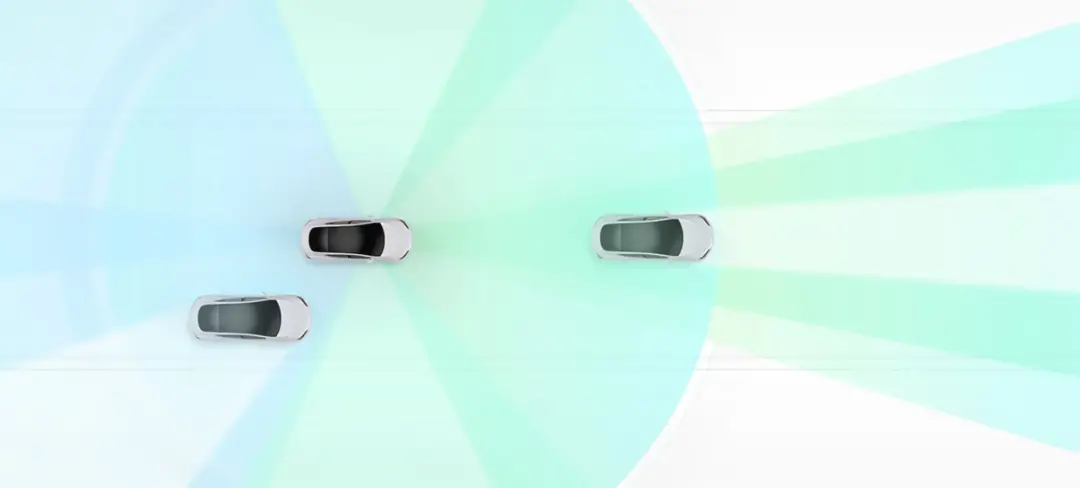

激光雷达(LiDAR)通过发射激光束并测量其返回时间,可以构建出周围环境极其精细的3D点云图像,解决了当时其他传感器无法解决的、致命的“Corner Case”(极端案例)。

它的角分辨率极高,能够清晰分辨行人的姿态、车辆的轮廓,甚至路面上的微小障碍物。L4/L5级别的商业自动驾驶领域,没有其他传感器能同时满足“高精度”和“测静态物体”这两个要求,为了实现最基本的自动驾驶功能和安全冗余,激光雷达的成本是车企必须付出的门票。

那么激光雷达既然已经这么强了,为什么还要研发其他传感器呢?

激光雷达性能极高,但也有其局限。激光属于红外光,波长很短。雨滴、雾滴、雪花、烟尘等颗粒的大小与激光波长接近,会导致激光发生散射和吸收,产生大量“噪声”点云。

而4D毫米波雷达能全天候工作,在恶劣天气下能利用其强大的穿透能力,率先发现前方障碍物并提供距离和速度数据。不过,毫米波雷达回波点非常稀疏,只能形成少量点云,无法像激光雷达那样勾勒出物体的轮廓和形状,还可能因为电子干扰产生“幽灵识别”。低分辨率让它注定无法成为主传感器,只能作为辅助上车。

所以,激光雷达和毫米波雷达各有优劣。二者不是替代关系,而是“常规场景靠毫米波控成本,复杂场景靠激光雷达保安全”的互补逻辑,不同的车型有不同配置。

L4 Robotaxi、豪华车通常采用“激光雷达为主,毫米波雷达为辅”的策略。不计成本地堆砌传感器,追求极致的安全和性能上限;L2+、L3量产经济车主要依赖“摄像头+毫米波雷达”,在车顶关键位置使用1~2颗激光雷达,形成高性价比的方案。

车企围绕传感器的选择争议,本质是一场关于“如何用最低成本实现最高安全”的技术探索和商业博弈。未来,各种传感器还将进一步融合,形成多样化的搭配方案。

大脑之争

端到端vs 模块化

如果说传感器是眼睛,那么算法就是大脑。

很长一段时间里,自动驾驶系统都采用模块化设计,整个驾驶任务被拆解为感知、预测、规划、控制等独立的子任务。每个模块各司其职,有独立的算法和优化目标,像一条分工明确的流水线。

模块化的优点是可解释强、开发并行、易于调试。但局部最优不等于全局最优,分而治之的模式也存在致命缺陷。每个模块在处理和传递信息时,都会进行一定程度的简化和抽象,导致原始的丰富信息在层层传递中丢失,整体表现难以达到最优。

2022—2023年,以特斯拉FSD V12为代表的“端到端”模型横空出世,颠覆了传统范式。这种方案的灵感来自人类的学习方式:新手司机不是先学习光学原理再研究交通规则,而是通过观察教练的操作直接学习驾驶。

端到端模型不再进行人为的模块划分,而是通过学习海量的人类驾驶数据,构建一个庞大的神经网络,直接将传感器输入的原始数据映射到方向盘转角、油门刹车等终端驾驶控制指令。

与模块化算法不同,端到端模型全过程没有信息损失、性能上限高,开发流程能进一步简化,但也存在着难以溯源问题点的黑箱难题。一旦发生事故,系统是难以判断哪个步骤出了错、后续应该怎样优化?

端到端的出现让自动驾驶从规则驱动迈向了数据驱动。然而,它的“黑箱”特质让许多更重视安全的车企望而却步,海量训练数据也只有拥有大规模车队的公司才能支撑。

因此,行业内出现了折中的“显式端到端”方案,即在端到端模型中保留可行驶区域、目标轨迹等中间输出,试图在性能与可解释性之间找到平衡。

“灵魂”之争

VLM vs VLA

随着AI发展,新的战场在大模型内部开辟。这关乎自动驾驶的灵魂,它应该是辅助驾驶的思考者(VLM),还是执行者(VLA)?

VLM视觉语言模型信奉协同,更追求过程可控,也被称为增强派。该路线认为AI大模型虽然强大,但幻觉在安全领域是致命的,应该让它做自己最擅长的事(理解、解释、推理),而把最终决策权交给经过数十年验证的、可预测、可调试的传统自动驾驶模块。

VLA视觉语言动作模型信奉涌现,追求结果最优,被称为端到端的终极形态。该流派主张只要模型足够大、数据足够多,AI就能自己从零开始学会驾驶的一切细节和规则,最终其驾驶能力会超越人类和基于规则的系统。

围绕VLM与VLA的争议就像模块化和端到端方案辩论的延续。

VLA存在着难以溯源的黑箱困境。如果一辆VLA车发生了一次急刹车,工程师几乎无法追溯原因。是因为它把阴影误判为坑洞?还是它学到了某个人类司机的不良习惯?无法调试、无法验证,这与汽车行业严格的功能安全标准是根本性冲突的。

而VLM系统整个过程可分解、可分析、可优化。如果遇到问题,工程师可以清晰地看到:传统感知模块看到了一个物体、VLM将其识别为“一个被风吹走的塑料袋”、规划模块因此决定“无需紧急刹车,轻微减速即可”。出了事故,责任清晰界定。

除了可解释性上的两极分化,训练成本也是车企犹疑不决的原因之一。

VLA需要海量的“视频-控制信号”配对数据,即输入一段8摄像头视频,输出同步的方向盘、油门、刹车信号。这种数据极其稀缺且制作成本高昂。

VLM本质是多模态大模型,可以利用互联网规模的、丰富的“图像-文本”配对数据进行预训练,再用驾驶相关的数据微调。数据来源更广,成本相对更低。

目前来看,VLM技术相对成熟,更容易落地,大部分主流车企和自动驾驶公司(包括Waymo、Cruise、华为、小鹏等)都走在 VLM路线上。而VLA路线的探索者则以特斯拉、吉利和理想为代表。据悉,吉利千里科技的千里浩瀚H9方案就采用了VLA大模型,具备更强的推理与决策能力,支持L3级智能驾驶解决方案。

回顾自动驾驶的流派之争,我们发现这些技术争论从未以一方完全胜出告终,而是在碰撞中相互融合,走向更高层次的统一。激光雷达与视觉正在融合为多模态感知系统;模块化架构开始吸收端到端的优势;大模型正在为所有系统注入认知智能。

而那些曾让行业困惑的谜题,看起来似乎没有标准答案,但最终都会成为技术迭代的注脚,推动自动驾驶继续向前发展。