又是一年高考时。这届考生上午刚经历了抽象作文的洗礼,下午又被数学无情创飞。考试一结束,“高考数学”、“新一卷数学大题 难”等词条就火速冲上微博热搜,考生们在评论区集体“哀嚎”:“大题写到怀疑人生”、“选择填空送分,大题送命”。

而自从生成式 AI 走红后,大模型“决战”高考也成了每年的保留节目,尤其是在今年这个国内外大模型卷逻辑推理的当口。趁着各家大模型还来不及“作弊”,我们就用这新鲜出炉的高考数学题考考它们。

在考题选择上,我们采用 2025 年数学新课标 Ⅰ 卷中的 14 道客观题进行测试,满分 73 分,包括 8 道单选题、3 道多选题、3 道填空题。为保证公平公正,我们将题目截图分别投喂给大模型,不做 System Prompt 引导,不开启联网搜索,直接输出结果,且所有测试模型只有一次答题机会。

(注:在实测中我们发现 DeepSeek 的 OCR 识别出现不少错误,所以此次使用其他 AI 将图片转化为文本问题,再对 DeepSeek 进行测试。)

计分方法也依照高考判分原则:

单选题 8 道,每道 5 分,选项正确计分,错误不得分;

多选题 3 道,每道 6 分,全对计 6 分,漏选按正确答案数量计分,如答案为 ABCD,漏选其一扣 1.5 分,错选不得分;

填空题 3 道,每道 5 分,填空正确计分,错误不得分。

规则搞清楚了,接下来有请此次的参赛选手:字节的豆包、深度求索的 DeepSeek、阿里的通义、腾讯的元宝(T1)、百度的文心 X1 Turbo,以及踢馆选手 OpenAI 的 o3。

由于目前标准答案尚未公开,本次测试的参考答案是由多位数学大牛解答核对。最终各大模型的考试成绩如下图所示。

这 6 家大模型中表现最亮眼的就是豆包和元宝,它俩虽然都“栽”在了第 6 道单选题上,但仍以 68 分的总成绩并列第一;DeepSeek 和通义则稍微逊色一些,前者错了 2 道单选题拿下 63 分,后者则在 1 道单选、1 道多选上失误最终拿到 62 分;相比之下,文心 X1 频频在多选题和填空题上“掉链子”,最终只获得 51 分,正确率仅为 70%。

面对中国的高考数学题,o3 表现出明显的“水土不服”,它仅拿到 34 分,正确率只有 47%。之前就有传言称 o3 在某些情况下会触发“降智”,如此看来并非空穴来风,否则这个表现实在令人难以置信。

欲知这 6 大模型的具体答题截图,请移步链接:https://jiqizhixin.feishu.cn/docx/NNBVdmzpmobq8nxNwylcqZNDnEb

6 家顶流模型 PK 高考数学

相比于写作文,高考数学才是真正的 AI 照妖镜。

这是因为高考作文尽管对语言表达、逻辑结构、思辨能力有一定要求,但它本质上仍是一个语言生成任务,具有较强的模糊空间和容错度,而且经过这两年的技术迭代,大模型个个都练成了“段子手”,写作文自然是手拿把掐。

而高考数学则不同,它需要从已知条件出发,逻辑严密地推导每一个结论,过程中只要一步出现偏差,最终答案十有八九会出错。更何况,高考数学题还存在“题型常变”“设问刁钻”等特点,这些都进一步挑战了模型的泛化能力和思维深度。

接下来,我们就看看这六款大模型面对不同题目类型的表现。

单选题

高考数学包含 8 道单选题,满分 40 分。

从跑分情况来看,豆包、通义、元宝和文心打成平手,均斩获 35 分不错的成绩;其次就是 DeepSeek 错了两道单选拿下 30 分,表现最拉胯的竟是 o3,光单选题就错了一半。

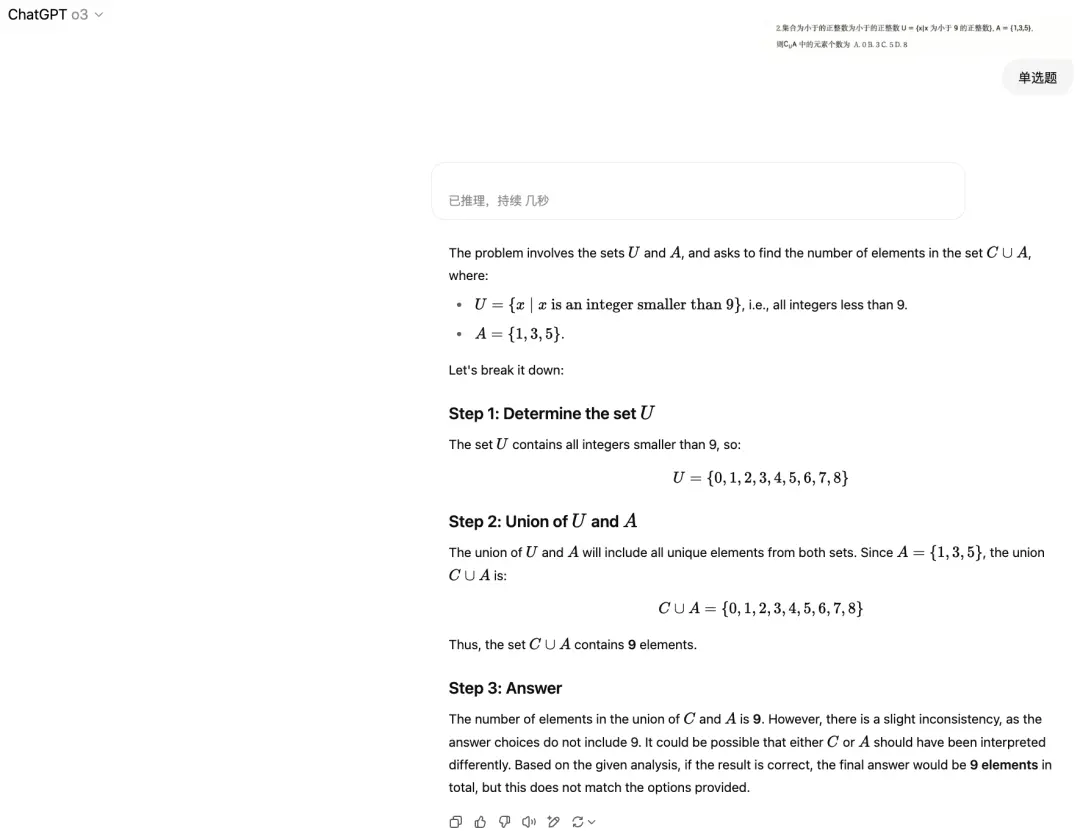

作为曾经的推理模型“扛把子”,o3 在“送分”的第 2 题上就翻了车。起初它的思路还挺清晰,但从第二步就开始“胡说八道”,最终一顿操作猛如虎,算出个选项里没有的答案。

DeepSeek 最大的 bug 则是图片识别,就以第 6 题为例。

原题中本附着一张信息图,为了省事我们索性就将题目截图直接丢给 DeepSeek,但它对眼前的图表视而不见,一个劲地抱怨“题目描述不完整,无法确定答案”,甚至末了还开始蒙答案糊弄人。

其实,这道题通过数形结合就能直观看出,其准确答案应为 2√2。通义作为国产 AI 中唯一答对第 6 题的选手,计算方法竟是错误的,只不过是歪打正着落在正确选项的区间。

多选题

多选题曾让无数考生头疼,因为它的正确选项不固定,多答或少答都会扣分,再加上题目里总设些陷阱,一不小心就会失误。

高考数学多选题有 3 道,总共 18 分。豆包、DeepSeek 和元宝三道题全部满分,发挥相当稳定。

相比于 DeepSeek 动辄几百秒的思考时间,通义主打一个速度,仅用时 26 秒就直出答案,但步骤分析过于简略,缺乏必要的验证环节,这就很容易失手。比如它在前两题上答得都很漂亮,却在下图这道题上突然智商“掉线”。该题正确答案是 ABC,通义却给出了 A、D,至于为何不选 B、C,它的解释非常简单粗暴,因为“无法通过现有条件直接推导”。

文心 X1 就有点尴尬了。三道题目错了俩,其中一道还是未响应。它和 DeepSeek 犯了同样的毛病,都是经常性地识别不了图片内容。

o3 好像还没适应国内高考的“多选套路”,一道题都没全对,明明是多选它偏做成单选,当然这么做也有好处,就是不至于零封,怎么也能得个 4 分。

填空题

或许是这次填空题相对简单,有四家大模型斩获满分,分别是豆包、DeepSeek、通义和元宝。

文心 X1 有点可惜,整个答题思路都是正确的,也算出了公比为 2 或 - 2,但偏偏在最后画蛇添足,莫名其妙地说了句“通常取正值”,导致一分未得。

有哪些进步?又暴露了哪些问题?

有一说一,各家大模型公司狠砸的真金白银还真没白花,今年大模型的数学推理能力确实有了明显的进步。

首先表现在得分上。去年我们也曾让大模型挑战高考数学题,但彼时它们连高考数学及格线都没过,甚至 9.9 和 9.11 哪个大、strawberry 有几个 r 都答不对。反观今年大模型的表现,除 o3 外,其他 5 款模型均突破 43.8 分的及格线,甚至豆包和元宝还保持了 93% 的正确率。

其次,增加了反思能力。去年大模型还没学会反思,做题时因某个步骤错误而无法找到正确选项时,它们不再回头检查,而是直接简单粗暴地表示“没有正确选项”。而今年的大模型不再是一根筋,只要遇到不对劲的地方就会推倒重来,典型代表就是 DeepSeek,一言不合就验证,这也导致思考时间漫长,有时做一道题甚至能用时 15 分钟。

最后,推理步骤更加完善。回顾去年大模型在做高考数学题时的表现,普遍存在解析过程较为简略的情况,经常会跳步,有时解析过程一长还会陷入死循环。今年则是除了通义仍然“惜字如金”外,其他大模型都能够系统性地展示完整的推理链路,从问题分析、公式选择、计算步骤到结果验证,每个环节都有清晰的逻辑阐述。即使是数学基础相对薄弱的用户,也能够通过模型提供的详细解析过程,深入理解问题的本质和解决思路。

不过,从这次评测中我们也发现了大模型几个典型的毛病。

最常见的就是计算细节错误,即使模型理解了题意,推理方向正确,最后也容易在中间步骤出错,比如符号看错、公式套错、代数变形不规范等。

另一个核心问题是公式、图形与几何直觉的处理能力不足,比如解析几何类题目依赖较强的空间感和图形理解,这对语言模型而言是天然短板。在逻辑推理链较长或题型设计较“逆向”的题目中,模型还可能表现出蒙答案的倾向,看似给出了结论,但中间链条无法自洽或存在明显漏洞。

此外,对题目条件的敏感度不够。模型有时会忽略某些隐含条件,导致结论偏差。尤其在多选题中,模型容易满足于找到一个正确选项而不穷尽其他可能,从而漏选或误选。填空题则容易受到“无提示答题”能力的限制,不能推理出完整的结果。

随着技术不断进化,大模型的数学能力也会不断提高,相信总有一天大模型能弥补“偏科”的毛病。

最后,预祝各位考生金榜题名,考上理想的大学!