一项由加拿大蒙特利尔大学心理学系领导的大规模研究显示,在某些标准化创造力测试上,生成式人工智能系统的得分已经超过普通人类参与者,但最具创造力的人类依然明显领先,这意味着AI更像是一种强大的创意辅助工具,而非人类创作者的替代者。

研究由蒙特利尔大学教授Karim Jerbi领衔,团队成员包括深度学习先驱、蒙特利尔大学教授Yoshua Bengio等人,他们对多款主流大语言模型(包括ChatGPT、Claude、Gemini等)进行了系统评估,并与逾10万名人类受试者的数据进行了对比,是目前规模最大的人机创造力比较研究之一。论文发表于《Scientific Reports》,题为《人类与大语言模型的发散性创造力》(Divergent creativity in humans and large language models)。

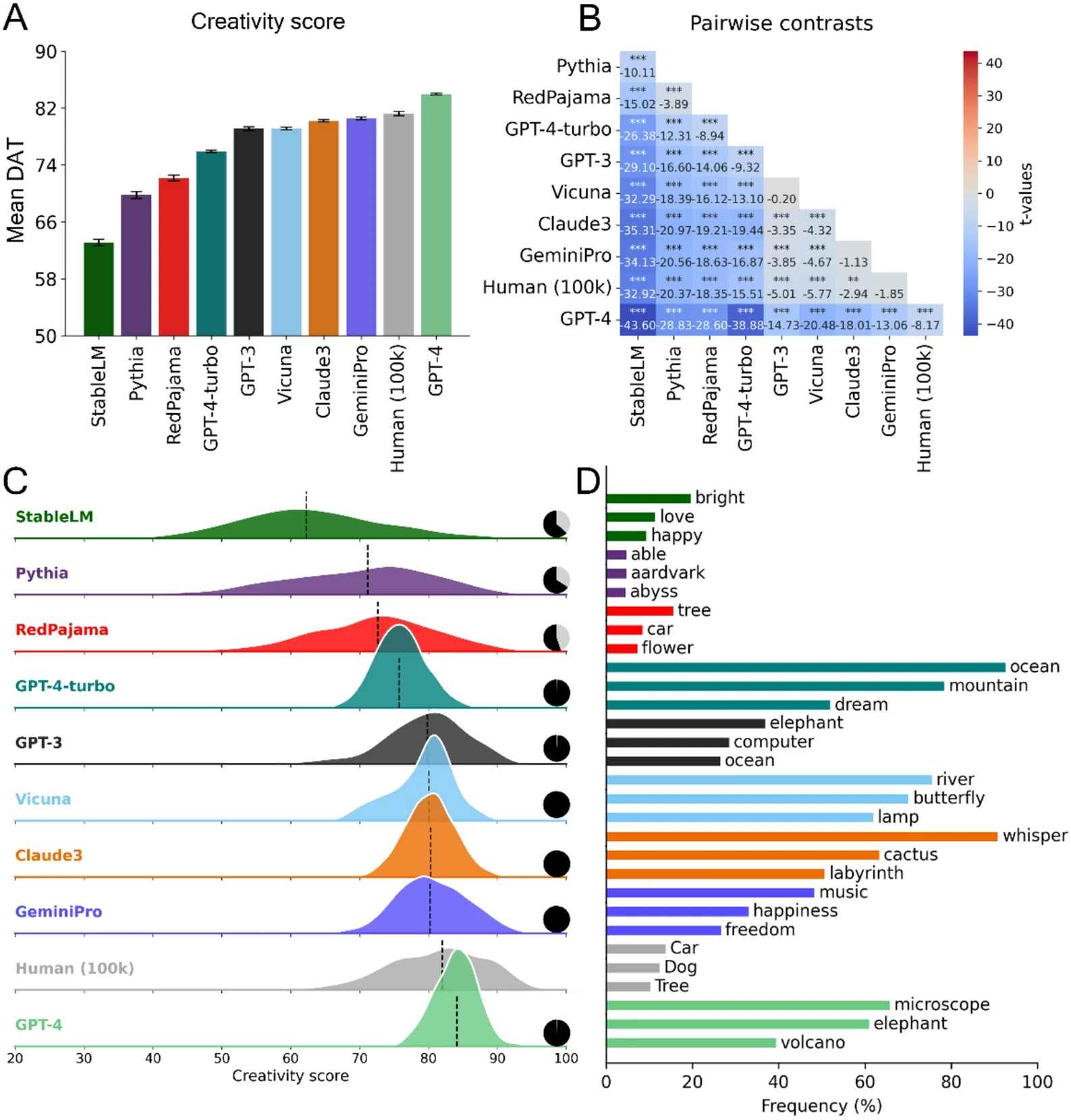

结果表明,在用于衡量“发散性语言创造力”的部分测试中,一些大语言模型(包括GPT‑4在内)的平均得分已经超过普通人类。Jerbi指出,这一发现“也许令人惊讶甚至不安”,但同样重要的是:哪怕是最强的AI系统,其表现仍低于最具创造力的人类个体。

进一步分析显示,当研究人员只看创造力水平处于人类“上半区”的那一半参与者时,这一群体的平均表现已经优于所有测试的AI系统,而在创造力排名前10%的顶尖人群中,人类与AI之间的差距更加明显。联合第一作者、蒙特利尔大学博士后Antoine Bellemare‑Pépin以及康考迪亚大学博士生François Lespinasse指出,这说明“最高水平的创造力仍旧是人类独有的优势”。

为了公平比较人类与AI,团队使用了多种方法,其中核心工具是由合作者、加拿大多伦多大学研究者Jay Olson开发的“发散联想任务”(Divergent Association Task,DAT)。这一心理测验要求参与者——无论是人类还是AI——在一次作答中给出10个在语义上彼此尽可能不同的词语,例如“银河、叉子、自由、藻类、口琴、量子、怀旧、天鹅绒、飓风”等,通过计算词语间的语义距离来衡量发散性思维能力。

先前研究表明,人类在DAT中的表现,与其他诸如创意写作、点子生成、创意问题解决等多种传统创造力测验的结果高度相关,因此可被视为更广泛创造性认知过程的一个快捷代理指标。DAT的另一个特点是操作简单、耗时短,通常只需两到四分钟即可完成,并已以在线形式向公众开放。

在完成基础词语测试后,研究团队进一步考察了这种“语言层面”的表现能否迁移到更复杂的创作任务中。他们安排AI系统与人类参与者在多个写作场景下正面较量,包括创作俳句(三行短诗)、撰写电影剧情概要以及创作短篇故事等,随后对作品质量进行评估。结果延续了此前模式:在一些任务中,AI的平均表现优于普通人类,但在人类创作者中水平较高的一部分,尤其是最擅长写作与故事构思的个体身上,人类优势依然明显。

研究还探讨了一个关键问题:AI的“创造力”是否可控、可调节?答案是肯定的。文章指出,一个重要技术参数是模型的“温度”(temperature),该参数影响输出内容的可预测性与多样性:温度较低时,AI生成的回答更保守、更可预期;温度较高时,输出更加多变、跳脱,往往会带来更具风险但也更具新意的联想。

此外,提示词(prompt)的写法同样影响显著。研究发现,当指令鼓励模型从词源学角度考虑词语的起源和结构时,AI更容易做出出人意料的联想,并在创造力评分上获得更高分数。这意味着,AI表现出的创造力在很大程度上依赖于人类的输入与引导,人机互动的设计正成为创意过程的核心环节之一。

在外界普遍担忧AI会“取代”创意工作者的背景下,这项研究给出了相对审慎的判断。Jerbi强调,尽管AI如今在某些标准化测验中达到乃至超越了人类平均创造力水平,但过分将人机关系理解为“竞争”是误导性的。在他看来,生成式AI首先是一种极其强大的创意工具,“它不会取代创作者,而会深刻改变创作者想象、探索与创作的方式——当然,这取决于人们是否选择使用它”。

论文结尾指出,与其预言创意职业的终结,不如将AI视作扩展想象力边界的“创意助手”。未来的创造力生态,可能不再是简单的人类对抗机器,而是人机协作的新范式:AI为人类提供灵感、变体与试验场,人类则在更高层次上把握审美、价值与意义。Jerbi认为,这类正面比较人类与机器能力的研究,正在迫使学界和公众重新思考“什么才算创造力”这一根本问题。